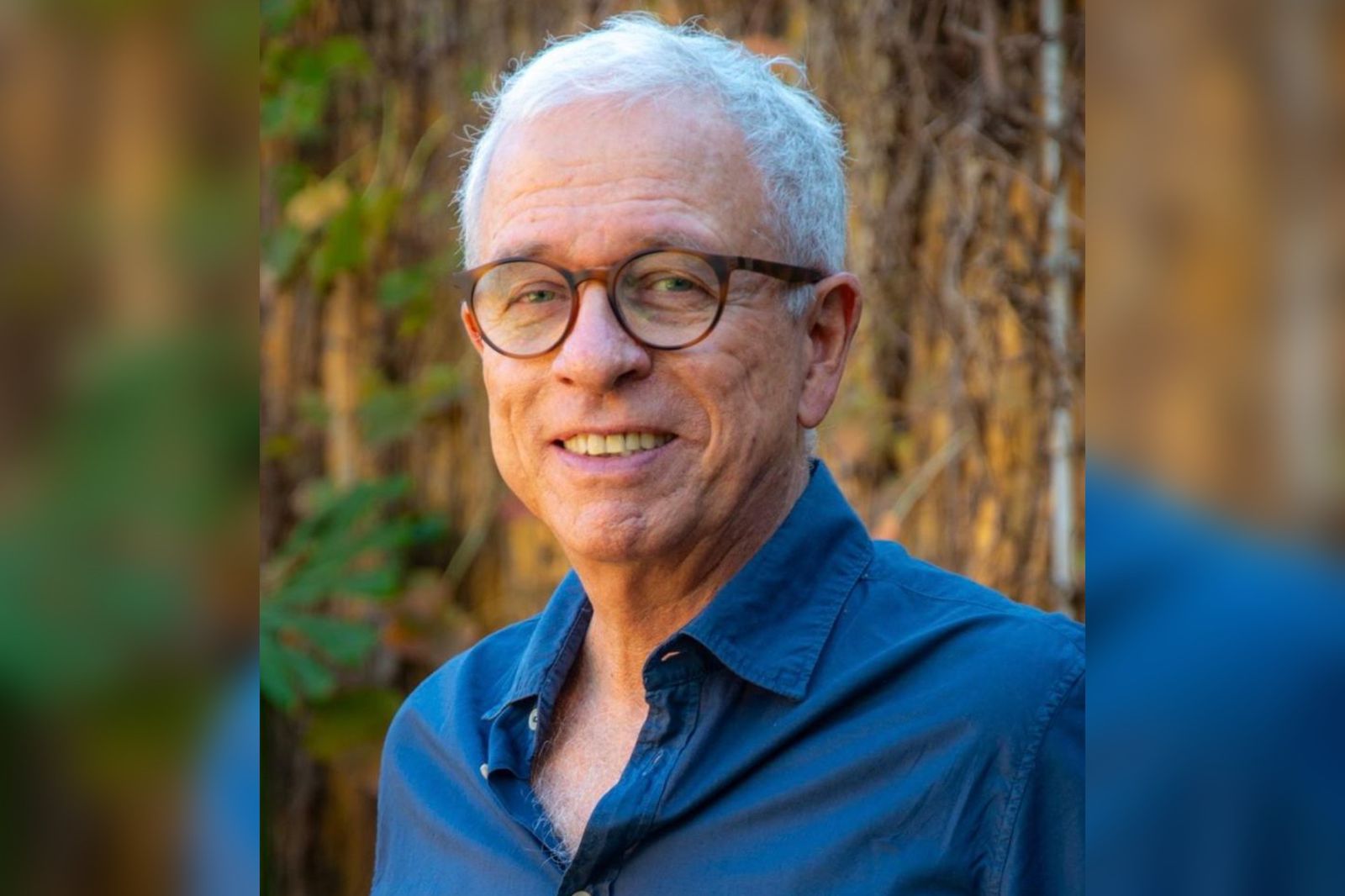

Tamarit: ‚ÄúLa inacci√≥n del Gobierno es realmente preocupante‚ÄĚ

05 de Marzo de 2026 | Primera Plana

Entrevistado para el programa “Amanece que no es poco”, el Dr. Guillermo Tamarit, rector de la UNNOBA, manifestó: “El CIN convocó a un par de reuniones, pero el intercambio no fue fructífero y las partes involucradas quedamos muy lejos de llegar a un entendimiento”, y agregó: “Ya no solo se trata del cumplimiento de la ley, sino que también observamos que en el desarrollo del 2026 los docentes y no docentes van a seguir perdiendo... Seguir leyendo

Refuerzan zonas comerciales con 40 nuevos policías en la calle

05 de Marzo de 2026 | Primera Plana

La ciudad sumó esta semana 40 efectivos de la Policía Bonaerense para intensificar la prevención del delito en los principales... Seguir leyendo

Brutal robo: entr√≥ por la fuerza a una casa, golpe√≥ al due√Īo y escap√≥ con un TV de 50 pulgadas

05 de Marzo de 2026 | Semanario El Tiempo

Un violento hecho de robo fue denunciado este martes por la madrugada por un hombre de 42 años, quien relató que alrededor de las 4:00... Seguir leyendo

Llega una nueva edici√≥n de la marat√≥n ‚ÄúLeandra Barros‚ÄĚ

La Maratón Leandra Barros tendrá lugar el viernes 13 y sábado 14 de marzo de 2026 en Pergamino y fue declarada de interés municipal por su relevancia deportiva, social y comunitaria. Organizada por la Fundación Leandra Barros y fiscalizada por la Asociación Atlética de Pergamino, la propuesta incluirá un paseo gastronómico abierto al

Douglas se prepara para su debut en el Torneo Federal 2026

El Consejo Federal de Fútbol celebró recientemente el sorteo del aguardado Torneo Federal 2026, revelando un calendario que promete emoción y competitividad. Uno de los momentos más esperados fue el anuncio del debut de Douglas, que tendrá lugar en su estadio como local contra Gimnasia de Chivilcoy. El Consejo Federal de Fútbol celebró

El ajuste y el límite argentino

Argentina no nació imperial. No tuvo Corte ni nobleza sedimentada como la que se consolidó en México y Perú, desde los imperios prehispánicos hasta los posteriores virreinatos de Nueva España y del Perú. No heredó jerarquías que enseñaran a aceptar el rango como destino. Aquí hubo puerto, pampa abierta, mestizaje e

REGION

Operativo de gran magnitud por incendio forestal en Costa Pobre

Ramallo

Dos ataques a balazos en pocas horas: una mujer en grave estado y dos aprehendidos

San Nicol√°s

El segundo parque industrial y una gestión a puro cuento

Junín